大模型技术的突破性进展正在重塑整个人工智能产业格局,我国企业在大模型效果和训推性能上的显著提升,不仅引发了存量市场的更新热潮,更促进了中小企业和创新型企业的广泛受益。人工智能基础平台(AI Infra)作为此轮变革的重要基石,对于技术创新和产业发展具有战略性意义。在这一历史性变革中,GpuGeek凭借其全栈式AI解决方案和创新服务模式,正在为AI技术的规模化落地和产业的智能化转型提供强有力的基础支撑。

全栈式技术架构,打造AI发展的坚实底座

作为面向算法工程师的一站式AI Infra平台,GpuGeek深度整合生态算力资源,构建了涵盖算力管理层、模型管理层、应用管理层的三大核心能力模型。平台通过对象存储、NAS存储、开发工具、模型部署、模型API等全方位技术服务,为,提供了从底层算力到上层应用的完整解决方案。

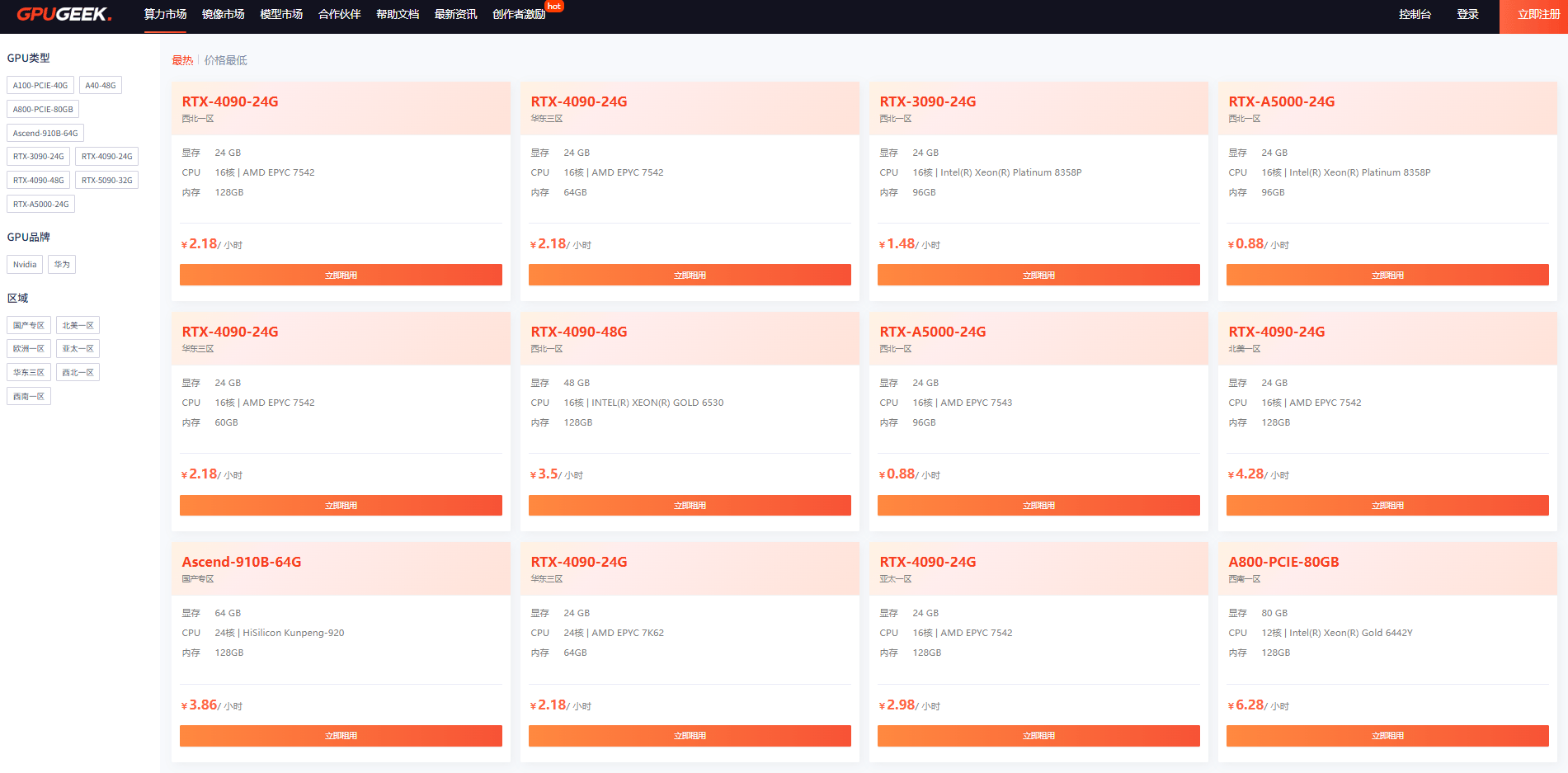

在算力资源配置方面,GpuGeek提供了从消费级RTX 5090/4090到专业级A5000/A40/A100,再到,A800的全系列GPU资源,满足不同规模和复杂度的AI项目需求。特别值得关注的是,平台新上线的华为昇腾910B 64G GPU资源,采用先进制程工艺和架构设计,在AI训练和推理场景中实现了显著的性能提升,为国产算力的发展注入了新的活力。

平台的裸金属服务器更是为高性能计算场景提供了优质解决方案。通过物理GPU直通技术,用户可以独占GPU资源,避免资源竞争,确保推理任务的稳定性和可靠性。这种服务模式特别适用于气象模拟、基因测序等需要FP64双精度计算的科学任务,以及Oracle数据库、SAP ERP等企业关键应用。

创新服务模式,降低AI应用门槛

GpuGeek致力于成为算力界的"滴滴",通过算力合作、联合运营、收益分成结算等创新方式,构建了高效的GPU算力交易网络,有效连接GPU供需双方。这种共享经济模式不仅提高了算力资源的利用效率,也显著降低了用户获取高性能计算资源的成本。

在用户体验方面,平台实现了真正的"开箱即用"。用户仅需半分钟就能完成账号注册、选择镜像并创建实例,平台内置的TensorFlow、PyTorch、PaddlePaddle、Colossal-AI、DeepSpeed等多种开源框架和CUDA版本,配合集成的在线IDE工具,让用户一键即可开启编程工作。

特别是GpuGeek创新的按需计费模式,包括包天、包周、包月以及竞价等多种选择,支持秒级计费,,可支持8卡GPU,用户能够根据自身需求随时切换GPU卡数且无需重新配置环境。这种灵活的计费方式真正实现了"按需付费,高效使用",为中小企业和个人,降低了AI技术应用的门槛。

全球化布局与生态建设,推动产业协同发展

GpuGeek在全球范围内的战略布局体现了其对AI技术全球化发展趋势的深刻理解。平台不仅在庆阳、宿迁、湖北等国内地区设有节点,还在香港、达拉斯、欧洲等地建立了海外节点。这种全球化的资源配置有效解决了算法工程师在跨国部署时面临的镜像下载慢、推理延迟高、数据合规难等痛点,实现了模型镜像秒级加载,推理延迟低至0.5秒。

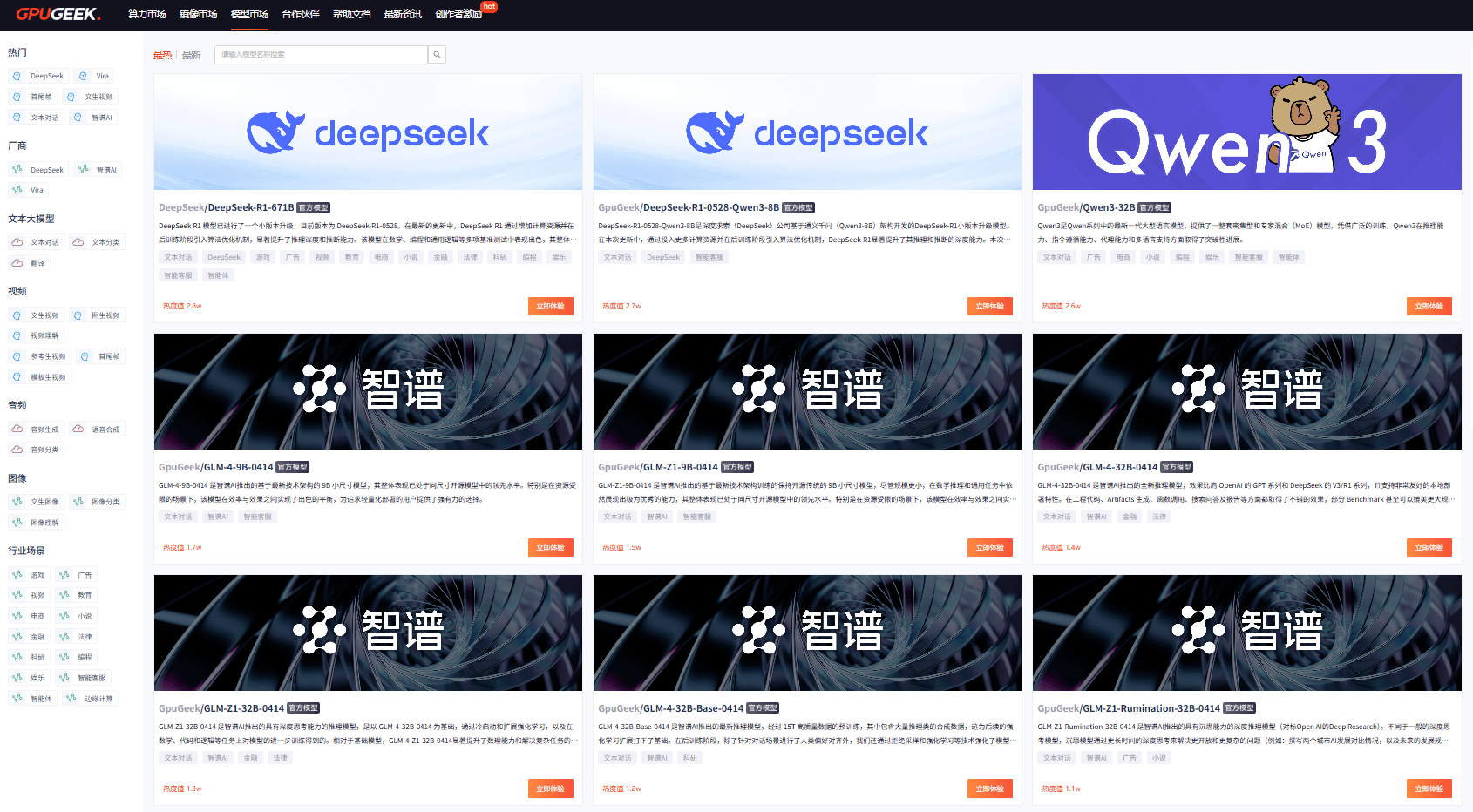

在模型生态建设方面,GpuGeek模型市场汇聚了业界最前沿的AI模型资源。平台第一时间上线了Qwen3-32B、智谱GLM-Z1系列、DeepSeek-V3等热门模型,为用户提供了丰富的模型选择。特别是Qwen3大模型以"混合推理架构"在数学、代码、多语言等领域的突破性表现,充分体现了技术创新对产业效率提升的重要作用。

GpuGeek还通过网络加速功能,专门解决访问国外学术网站卡顿的问题,覆盖主要学术资源网站,为科研工作者和,提供了更加便捷的研发环境。同时,通过开源数据集共享、用户社区建设等方式,GpuGeek正在构建一个开放、协作的AI生态系统。

面向未来,GpuGeek将继续坚持开放合作的态度,积极拥抱更多国内优秀的芯片厂商和解决方案提供商,构建更加丰富、更具弹性的国产算力资源池。通过不断优化国产算力资源的调度、管理和使用体验,确保不同算力资源的高效协同,为客户提供"一站式"的国产算力解决方案。

在AI技术快速发展和产业数字化转型的关键时期,GpuGeek正以其技术创新、服务创新和生态建设,为AI技术的普及应用和产业的智能化升级提供着强有力的基础支撑。作为新一代企业数智化转型的重要底座,GpuGeek不仅在技术层面推动着AI基础设施的完善,更在商业模式和服务理念上引领着行业的发展方向,为构建更加开放、高效、普惠的AI生态贡献着重要力量。