人工智能伦理与安全研究,主任曾毅

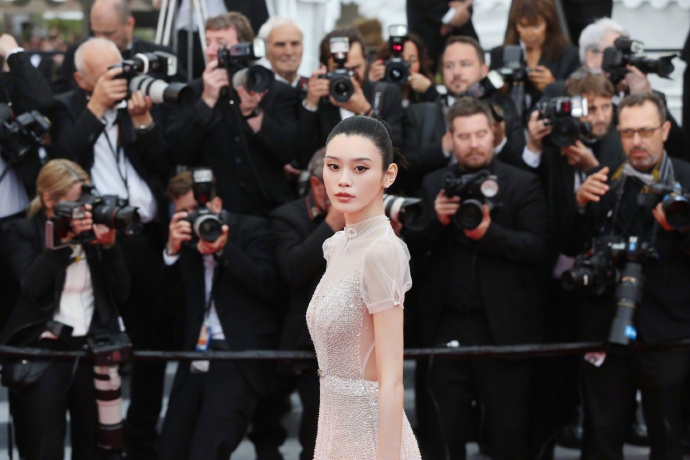

《人工智能北京共识》发布会现场。新京报记者 吴宁 摄

《人工智能北京共识》发布,提出了各个参与方应遵循的有益于人类命运共同体的15条原则。

其中研发方面,要服从人类的整体利益,设计上要合乎伦理;使用方面要避免误用和滥用,确保利益相关者对其权益所受影响有充分的知情与同意;治理方面,对人工智能部分替代人类工作保持包容和谨慎态度。共识的发布,为规范和引领人工智能健康发展提供了“北京方案”。

昨日,北京智源人工智能研究院联合北京大学、清华大学等单位发布《人工智能北京共识》,《人工智能北京共识》提出服从人类的整体利益,人工智能在设计上要合乎伦理,体现多样性与包容性等。

当天,北京智源人工智能研究院人工智能伦理与安全研究,揭牌成立。研究,将围绕人工智能伦理与安全的理论探索、算法模型、系统平台、行业应用等开展一系列研究。

研发设计上要合乎伦理

《人工智能北京共识》由北京智源人工智能研究院联合北京大学、清华大学、中国科学院自动化研究所、中国科学院计算技术研究所、新一代人工智能产业技术创新战略联盟等高校、科研院所和产业联盟共同发布。

《人工智能北京共识》提出的15条原则中,研发方面,提倡要有益于增进社会与生态的福祉,服从人类的整体利益,设计上要合乎伦理,体现多样性与包容性,尽可能地惠及更多人,要对潜在伦理风险与隐患负责,提升技术水平控制各种风险,并,范围共享人工智能发展成果。

使用方面,提倡善用和慎用,避免误用和滥用,以,化人工智能技术带来的益处、最小化其风险,应确保利益相关者对其权益所受影响有充分的知情与同意,并能够通过教育与培训适应人工智能发展带来的影响。

在治理方面,对人工智能部分替代人类工作保持包容和谨慎态度,鼓励探索更能发挥人类优势和特点的新工作,广泛开展国际合作,共享人工智能治理经验。人工智能的准则与治理措施应做到适应和适度,并开展长远战略设计,以确保未来人工智能始终保持向对社会有益的方向发展。

实现人工智能“自律”“有序”

人工智能伦理与规范是未来智能社会的发展基石,已经引起了各国政府和学术界、企业界等的广泛关注。欧盟、日本等国际组织和国家,均发布了人工智能的伦理准则。

《人工智能北京共识》强调促进人工智能相关准则的“落地”,为未来打造“负责任的、有益的”人工智能。

人工智能伦理与安全研究,主任曾毅认为,这一共识的发布,为规范和引领人工智能健康发展提供了“北京方案”。北京是人工智能国际化大都市和国家新一代人工智能创新发展试验区,城市,《共识》有助于表达北京发展人工智能与其他地区和世界范围形成的共识。

■ 对话

人工智能伦理与安全研究,主任曾毅:

人工智能系统还不能准确了解人类价值观

为降低人工智能发展过程中可能存在的技术风险和伦理隐患,北京智源人工智能研究院专门成立人工智能伦理与安全研究,,中国科学院自动化研究所研究员曾毅任研究,主任。对此,新京报记者对曾毅进行了专访。

谈人工智能伦理:

机器和人的价值观校准是,挑战

新京报:研究人工智能伦理与安全是否具有紧迫性?

曾毅:近年来,随着人工智能研究与产业发展,一些相关伦理与社会问题逐渐凸显,例如人工智能带来的安全风险、隐私、算法歧视、行业冲击、失业、收入分配差异扩大、责任分担、监管难题、以及对人类道德伦理价值的冲击等。

因此,我国急需开展人工智能伦理与安全的研究,将对人工智能风险、安全、伦理的思考模型化、算法化、系统化等多方的努力,确保人工智能向对人类和自然有益的方向发展。

新京报:伦理研究出于何种考虑?

曾毅:人工智能伦理准则是各个国家、组织进行对话的重要议题。目前,人工智能系统不能真正理解人类的价值观。举例说,你需要很快从A点跑到B点,如果中途有个孩子过来,你一定会绕开他,不会为了节省时间,撞到孩子也在所不惜。但是机器为了更快达到目标,可能做出相反的选择。

所以如何使机器自主学习人类价值观、避免风险是人工智能伦理研究中重要主题,叫做价值观校准。这是人工智能研究中的圣杯,也是人工智能,的挑战之一。

谈人工智能风险:

改变一个像素飞机可能被认成狗

新京报:如何看待人工智能发展中的安全风险?

曾毅:人工智能的发展过程中已出现一些潜在的风险,例如一张飞机的图片,如果改变其中关键的一个像素,人还是觉得图片中是飞机。但目前很多深度学习模型可能会颠覆认知,认为那是一只狗。这说明现在机器学习算法的自适应性还不能应对实时变化的环境、噪声以及恶意攻击。

机器学习的前提假设,是输入的数据能很好地描述实际世界,但实际情况是训练数据往往比较理想化或者片面,而真实世界是非常复杂、多变的。因此,我们未来研发人工智能模型要向低风险、高安全方向发展。

新京报:如何看待此次《北京共识》的提出,对人工智能部分替代人类工作保持包容和谨慎态度?

曾毅:人工智能的研发如果不考虑潜在的风险,不考虑服务于人类、构建负责任的、对社会有益的人工智能,就有可能带来不可估量的负面影响。因此在《人工智能北京共识》中,就倡导对通用智能、超级智能潜在的风险进行持续研究与分析。

谈研究,工作:

将探索用户撤销个人数据授权

新京报:《人工智能北京共识》提到避免技术误用和滥用,如何做到?

曾毅:在构建人工智能平台时,企业往往不知道用户会如何使用平台。其实应该做一些设计,如果出现人工智能滥用,平台应该能自动化检测、告知和避免,这是所有人工智能研究者和企业应该关注的问题。

新京报:如何保证人工智能中的数据安全?

曾毅:欧盟相关企业对《通用数据保护条例(GDPR)》的实践表明,采取更严格的数据保护机制,虽然一开始,相关企业和服务方需要付出额外努力适应条例,但是随后往往带来用户量的增加。用户反馈说明,用户更相信遵守数据保护条例的企业,更愿意选择为保护用户数据安全做出努力的产品与服务。

研究,将与企业开展联合实践,建设数据安全示范应用系统,,限度防止数据泄密,降低风险,探索允许用户撤销个人数据授权的机制及计算平台,提升个人数据安全。

新京报记者 张璐